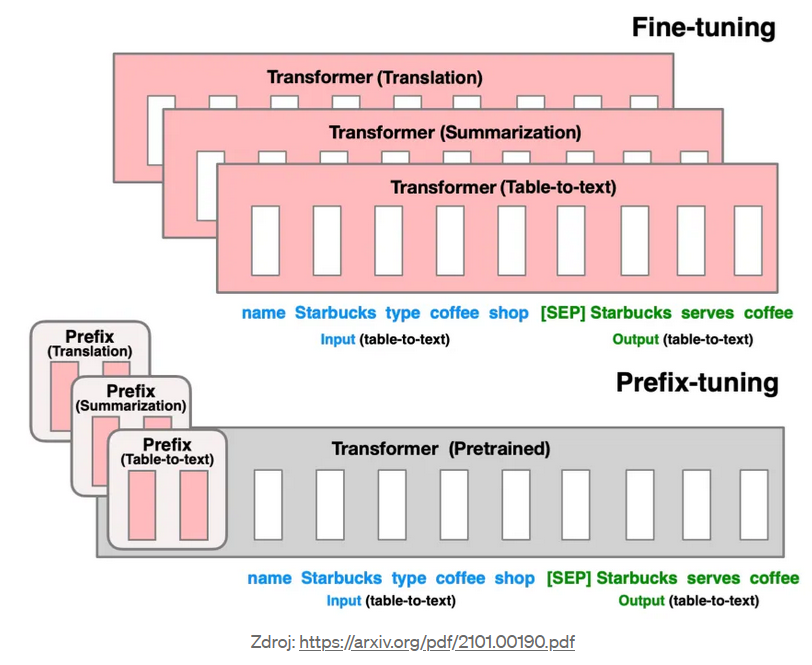

Na tomto obrázku je ilustrován způsob, jakým se umělá inteligence učí specifické úkoly, jako je psaní textu o kavárnách Starbuks.

Představte si, že máte velmi chytrého robota, který už se naučil dělat spoustu věcí, ale teď chcete, aby se stal expertem na psaní o kavárnách. Učíte ho, dáváte mu spoustu příkladů a on se z těchto příkladů učí. Nakonec se naučí psát skvěle o kavárnách. To je Fine-tuning – specializovaný trénink na určitý úkol.

Nyní si představte, že místo toho, abyste robota učili od začátku, dáte mu klobouk s nápisem „Expert na kavárny Starbugs“. Když si klobouk nasadí, najednou začne mluvit o kavárnách, protože klobouk mu připomene, co by měl dělat. Nemusíte ho nic učit; klobouk mu dá vědět, že by měl používat vše, co už ví, ale teď to aplikovat na kavárny. To je Prefix-tuning – dáváte AI návod, co má dělat, aniž byste museli cokoli měnit v tom, jak myslí.

Co je prefix?

Prefix je slovo nebo skupina slov, která se přidává na začátek jiného slova nebo věty, aby změnila nebo upřesnila její význam.

Modely generování přirozeného jazyka (NLG), jako je řada GPT, umožnily pozoruhodný pokrok v úlohách podmíněného generování textu, jako je sumarizace a převod z tabulky na text.

Jemné doladění těchto velkých předtrénovaných modelů na navazujících úlohách NLG však vyžaduje aktualizaci všech parametrů modelu, což je výpočetně nákladné.

Naštěstí výzkumníci identifikovali lehké metody jemného ladění, které snižují počet parametrů, které je nutné aktualizovat při dolaďování modelu pro konkrétní úlohu. Jednou z takových metod je ladění prefixů, které navrhli Li a Liang (2021) . Ladění prefixů udržuje parametry předtrénovaného modelu pevné a trénuje pouze malou souvislou „předponu“, která je vložena do modelu.

Konkrétně ladění prefixů přidává naučený spojitý vektor ke vstupu. Například při shrnutí by se před vstupní dokument přidal předpona. Předpona je vyladěna tak, aby nasměrovala model tak, aby provedl sumarizaci, zatímco velký předtrénovaný model zůstane pevný. To je mnohem efektivnější a vyžaduje doladění pouze 0,1 % parametrů ve srovnání s úplným doladěním.

Ladění prefixů čerpá inspiraci z metod výzvy jako v GPT-3, ale spíše než pomocí samostatných tokenů optimalizuje souvislý vektor prefixů. Článek ukazuje, že ladění prefixů se může rovnat výkonu úplného jemného ladění u úloh typu tabulka-text a sumarizačních úloh při použití 1000x méně parametrů na úlohu.

Služby Prompt Engineering

Jako součást mé služby vám mohu nabídnout expertní využití techniky Ladění prefixů pro vaše AI modely. Toto zahrnuje:

Vytváření efektivních prefixů: Vytvořím specifické prefixy, které modelu pomohou pochopit, jaký druh odpovědi je očekáván. Tyto prefixy budou pečlivě navrženy tak, aby byly relevantní pro váš konkrétní úkol a aby modelu poskytly jasné směry.

Optimalizace komunikace s modelem: Prefixy slouží jako nápovědy pro model, které mu pomáhají lépe pochopit, co od něj očekáváme. Jako expert na tuto techniku se zaměřím na optimalizaci těchto nápověd, aby byla komunikace s modelem co nejefektivnější.

Přizpůsobení modelu vašim potřebám: Na základě prefixů, které poskytnu modelu, bude schopen lépe pochopit a splnit vaše specifické požadavky. Tímto způsobem můžeme dosáhnout výsledků, které jsou přizpůsobeny vašim potřebám a očekáváním.

Kontinuální učení a vylepšování: Technika Ladění prefixů umožňuje modelu neustále se učit a vylepšovat. Jako součást mé služby budu pravidelně aktualizovat a rozšiřovat soubor prefixů, aby model mohl pokračovat v učení a zlepšování.